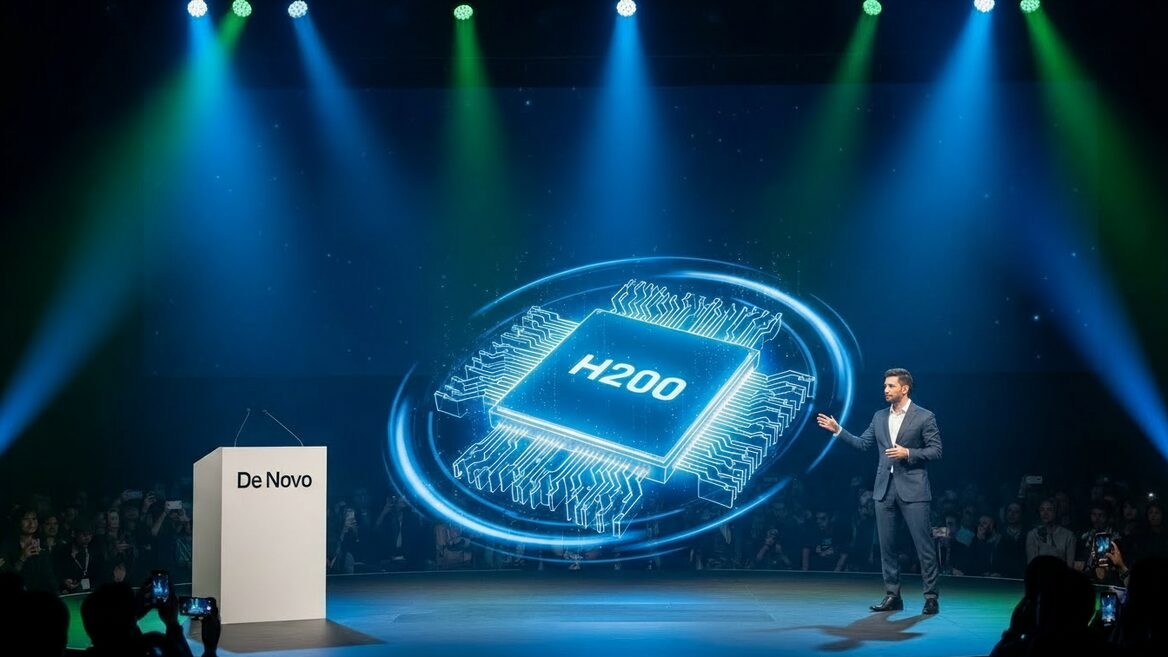

Національний оператор хмар та датацентрів De Novo оголошує про доступність для користувачів NVIDIA H200, найпродуктивніших тензорних прискорювачів для великих мовних моделей. Це найсучасніше рішення для задач генеративного штучного інтелекту, яке тепер доступне в українській хмарі. Тепер у De Novo — найбільша GPU-інфраструктура в Україні — H200, H100, A100, L40S, L4. Вона дозволяє бізнесу навчати складні ШІ-моделі без передачі даних за кордон.

Читайте также: Користувачі Claude Code заявили про падіння лімітів: Anthropic послалися на кінець святкового бонусу

Ключова перевага H200 — це не просто «більша потужність», а революційна підсистема із використанням високошвидкісної стекової пам’яті HBM3e. Раніше розвиток ШІ стримувала саме швидкість обміну даними, а не потужність процесорів. Нові карти усувають цей бар’єр, дозволяючи обробляти значно більші обсяги інформації для ШІ-моделей.

Технічні характеристики у цифрах:

- Пропускна здатність підсистеми пам’яті: 4,8 ТБ/с (на 43% швидше за попередника H100).

- Обсяг пам’яті: 141 ГБ (на 76% більше, ніж у H100).

- Ефективність: Час обробки запитів (інференс) моделями рівня Llama 3 70B прискорюється до +50%.

Завдяки збільшеному обсягу пам’яті, великі мовні моделі (LLM) тепер можуть працювати на одній відеокарті без необхідності шардування (поділу задачу на частини), що значно підвищує швидкодію. Новий високошвидкісний комунікаційний інтерфейс NVIDIA NVLink четвертого покоління, з пропускною здатністю до 900 ГБ/с, дозволяє об’єднувати до восьми прискорювачів H200 в єдиний обчислювальний вузел із загальним пулом пам’яті понад 1,1 ТБ. Це відкриває нові горизонти, дозволяючи українським компаніям вирішувати надскладні завдання.

У галузі генеративного AI (GenAI) H200 ідеально підходять для створення високоточних RAG-систем, які працюють із закритими корпоративними базами знань, наприклад, для автоматизації юридичного аналізу, обробки медичних даних або створення технічної документації. Також такі потужності критично важливі для навчання масштабних LLM з мільярдами параметрів та створення високопродуктивних чат-ботів чи рекомендаційних систем.

Читайте также: Звіт Block Scholes фіксує зростання токенізованих акцій і називає Bitget одним із ключових драйверів ринку

Для користувачів, які працюють із LLM та інференсом у середовищах розробки та продуктиву, у хмарі De Novo доступна платформа AI Studio — передналаштоване середовище для запуску й оптимізації моделей. AI Studio пропонує готові контейнерні оточення з підтримкою CUDA, PyTorch, TensorRT, векторних баз даних та інструментів для RAG-систем. Завдяки інтегрованим API розробники можуть швидко розгортати моделі на H200 без ручної підготовки інфраструктури, зосередившись на безпосередньо на продукті, а не на налаштуваннях.

Усі обчислення відбуваються в захищеній хмарі De Novo (сертифікати ISO 27001, PCI DSS, КСЗІ), що гарантує юридичну чистоту даних. Нові карти повністю сумісні з популярними інструментами (CUDA, PyTorch, Kubernetes), що дозволяє розробникам миттєво отримати приріст продуктивності без перебудови IT-інфраструктури. Отже, H200 у хмарі De Novo — це інструмент, що дозволяє українським компаніям увійти в нову еру мультимодальних та генеративних моделей та підвищити конкурентоспроможність на глобальному ринку ШІ.

https://dev.ua/news/de-novo-1767694847